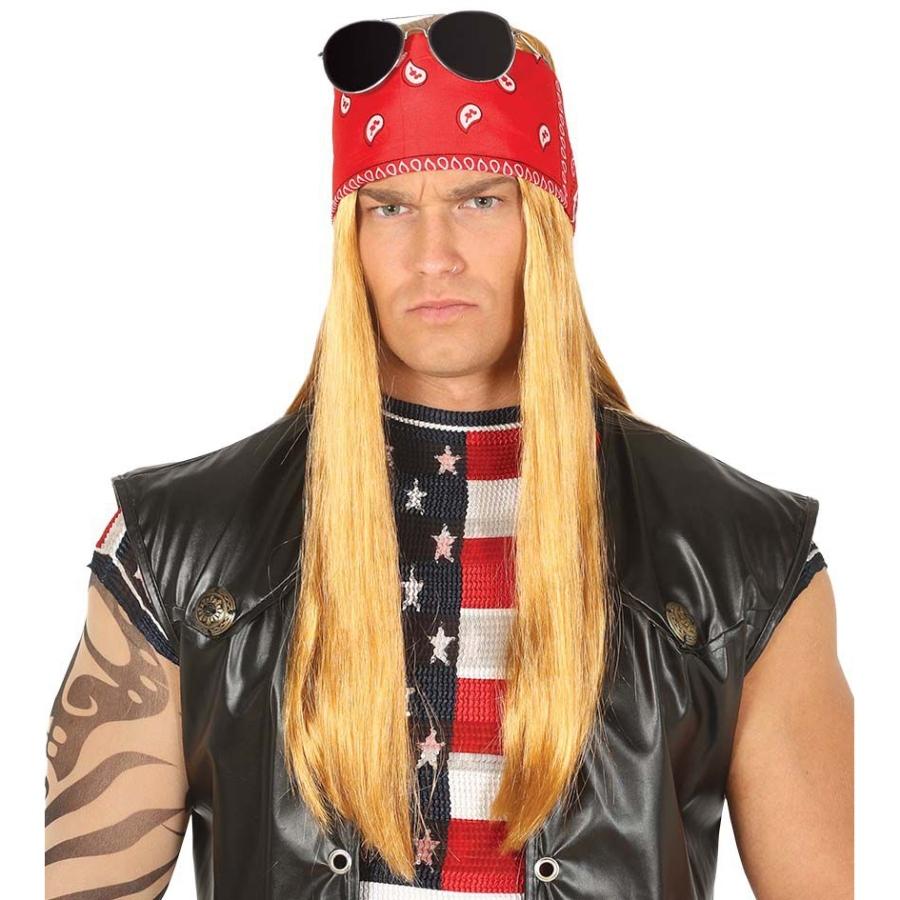

Smiffys-48099 Kit rockero Duro, Rubio, con Peluca, pañuelo para la Cabeza, Barba y Gafas, Color, Applicable (Smiffy'S 48099) : Amazon.es: Juguetes y juegos

NET TOYS Pañuelo Americano Bandana EE. UU. Paño de Cabeza Barras y Estrellas Accesorio de Cabeza de Hombre Tela para la Cabeza rockero Biker Accesorio Disfraz Motero : Amazon.es: Juguetes y juegos

Chico rockero en gafas negras, bufanda, pañuelo y con una calavera en sus manos sobre un fondo de luz Fotografía de stock - Alamy

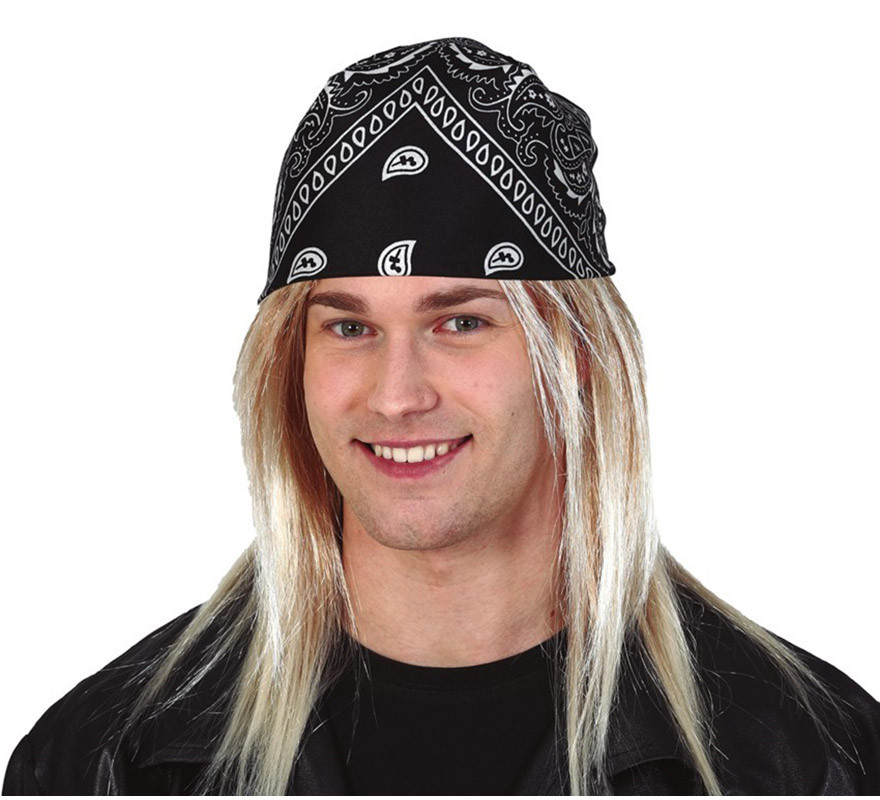

Comprar Pañuelo Hard Rock > Complementos para Disfraces > Accesorios para la cabeza Disfraces > Accesorios Varios Cabeza para Disfraces | Tienda de disfraces en Madrid, disfracestuyyo.com